생성형 AI 혁명의 심장

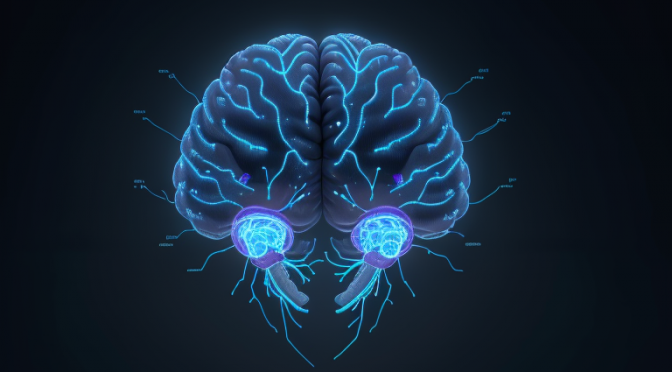

생성형 AI는 최근 몇 년간 급격한 발전을 거듭하고 있으며, 이는 다양한 산업 분야에서 혁신을 가져올 수 있는 기술입니다. 생성형 AI의 핵심은 신경망과 딥러닝에 있습니다.

3줄 요약

- 생성형 AI는 데이터를 생성하고 변형하는 데 사용됩니다.

- 신경망과 딥러닝은 생성형 AI의 핵심 기술입니다.

- 생성형 AI는 다양한 산업 분야에서 혁신을 가져올 수 있습니다.

핵심: 생성형 AI의 핵심 기술과 실무 적용을 이해하는 것이 중요합니다.

생성형 AI는 이미지 생성, 음성 합성, 문자 생성 등 다양한 분야에서 사용되고 있습니다. 이러한 기술은 의료, 금융, 엔터테인먼트 등 다양한 산업 분야에서 혁신을 가져올 수 있습니다.

| 분야 | 생성형 AI의 적용 |

|---|---|

| 의료 | 의료 이미지 분석, 의료 데이터 생성 |

| 금융 | 금융 데이터 분석, 금융 모델링 |

| 엔터테인먼트 | 영상 게임, 영화, 음악 생성 |

요약: 생성형 AI는 다양한 산업 분야에서 혁신을 가져올 수 있는 기술입니다.

실무 적용 체크리스트

- 데이터 수집: 생성형 AI를 사용하기 위해서는大量의 데이터가 필요합니다.

- 모델링: 생성형 AI 모델을 개발하고 훈련시키는 것이 중요합니다.

- 테스트: 생성형 AI 모델을 테스트하고 평가하는 것이 중요합니다.

핵심: 생성형 AI의 실무 적용을 위해서는 데이터 수집, 모델링, 테스트가 중요합니다.

FAQ

Q: 생성형 AI는 무엇인가?

A: 생성형 AI는 데이터를 생성하고 변형하는 데 사용되는 기술입니다.

Q: 생성형 AI의 핵심 기술은 무엇인가?

A: 생성형 AI의 핵심 기술은 신경망과 딥러닝입니다.

Q: 생성형 AI는 어떤 산업 분야에서 사용될 수 있는가?

A: 생성형 AI는 의료, 금융, 엔터테인먼트 등 다양한 산업 분야에서 사용될 수 있습니다.

Q: 생성형 AI의 실무 적용을 위해서는 무엇이 중요합니까?

A: 생성형 AI의 실무 적용을 위해서는 데이터 수집, 모델링, 테스트가 중요합니다.

Q: 생성형 AI는 어떻게 사용할 수 있는가?

A: 생성형 AI는 다양한 라이브러리와 프레임워크를 사용하여 개발할 수 있습니다.

관련 글 추천