BERT 계열 사전 학습 언어 모델의 진화

핵심: BERT 계열 사전 학습 언어 모델은 자연어 처리 분야에서 큰 발전을 이루어냈습니다.

3줄 요약

- BERT는 사전 학습 언어 모델의 대표적인 예입니다.

- RoBERTa, DistilBERT 등은 BERT의 변형입니다.

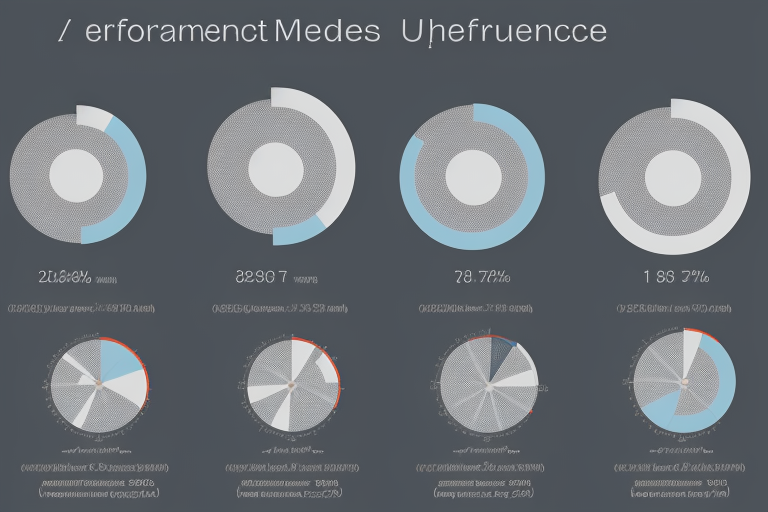

- 각 모델은성능, 효율성, 적용 분야에서 차이를 보입니다.

BERT 계열 모델은 자연어 처리 분야에서 널리 사용되고 있습니다. 비교를 통해 각 모델의장점과단점을 파악할 수 있습니다.

| 모델 | 성능 | 효율성 | 적용 분야 |

|---|---|---|---|

| BERT | 높음 | 중간 | 자연어 처리 전반 |

| RoBERTa | 높음 | 높음 | 자연어 처리 전반 |

| DistilBERT | 중간 | 높음 | 실시간 처리 |

요약: BERT 계열 모델은 각기다른 특징을 가지고 있습니다.

실무 적용 체크리스트

- 모델 선택: 목적에 따라 적절한 모델을 선택하세요.

- 데이터 준비: 모델에 입력할 데이터를 준비하세요.

- 모델 학습: 모델을 학습시키세요.

- 모델 평가: 모델의 성능을 평가하세요.

FAQ

Q: BERT 계열 모델은 무엇인가요?

A: BERT 계열 모델은 사전 학습 언어 모델의 대표적인 예입니다.

Q: RoBERTa와 DistilBERT는 무엇이 다르나요?

A: RoBERTa는 성능이 높고, DistilBERT는 효율성이 높습니다.

Q: BERT 계열 모델을 어떻게 적용할 수 있나요?

A: 자연어 처리 전반에 적용할 수 있습니다.

Q: 모델을 선택할 때 무엇을 고려해야 하나요?

A: 목적, 데이터, 성능, 효율성 등을 고려해야 합니다.

Q: 모델을 학습시킬 때 무엇을 주의해야 하나요?

A: 데이터의 질, 모델의 복잡도, 학습 시간 등을 주의해야 합니다.